VertexAI PaLM2 Chat

警告

自 2024 年 2 月 15 日起,用于 Google AI 服务和工具的 PaLM2 API 已被弃用。6 个月后,PaLM API 将被停用,这意味着用户将无法在提示中使用 PaLM 模型、调整新的 PaLM 模型或对 PaLM 调整的模型进行推理。

生成式语言 PaLM API 允许开发人员使用 PaLM 模型构建生成式 AI 应用程序。大型语言模型 (LLM) 是一种功能强大且用途广泛的机器学习模型,它使计算机能够通过一系列提示来理解和生成自然语言。PaLM API 基于 Google 的下一代 LLM,PaLM。它擅长各种不同的任务,例如代码生成、推理和写作。您可以使用 PaLM API 为内容生成、对话代理、摘要和分类系统等用例构建生成式 AI 应用程序。

基于 模型 REST API。

先决条件

要访问 PaLM2 REST API,您需要从 makersuite 获取访问 API 密钥。

| 目前,PaLM API 在美国以外不可用,但您可以使用 VPN 进行测试。 |

Spring AI 项目定义了一个名为 spring.ai.vertex.ai.api-key 的配置属性,您应该将其设置为获得的 API 密钥 的值。导出环境变量是设置该配置属性的一种方法。

export SPRING_AI_VERTEX_AI_API_KEY=<INSERT KEY HERE>自动配置

Spring AI 为 VertexAI Chat 客户端提供 Spring Boot 自动配置。要启用它,请将以下依赖项添加到项目的 Maven pom.xml 文件中

<dependency>

<groupId>org.springframework.ai</groupId>

<artifactId>spring-ai-vertex-ai-palm2-spring-boot-starter</artifactId>

</dependency>或添加到您的 Gradle build.gradle 构建文件中。

dependencies {

implementation 'org.springframework.ai:spring-ai-vertex-ai-palm2-spring-boot-starter'

}| 请参阅 依赖项管理 部分,将 Spring AI BOM 添加到您的构建文件中。 |

聊天属性

前缀 spring.ai.vertex.ai 用作属性前缀,允许您连接到 VertexAI。

| 属性 | 描述 | 默认值 |

|---|---|---|

spring.ai.vertex.ai.ai.base-url |

要连接的 URL |

|

spring.ai.vertex.ai.api-key |

API 密钥 |

- |

前缀 spring.ai.vertex.ai.chat 是属性前缀,允许您配置 VertexAI Chat 的聊天模型实现。

| 属性 | 描述 | 默认值 |

|---|---|---|

spring.ai.vertex.ai.chat.enabled |

启用 Vertex AI PaLM API 聊天模型。 |

true |

spring.ai.vertex.ai.chat.model |

这是要使用的 Vertex Chat 模型 |

chat-bison-001 |

spring.ai.vertex.ai.chat.options.temperature |

控制输出的随机性。值可以在 [0.0,1.0] 范围内,包含边界。更接近 1.0 的值将产生变化更大的响应,而更接近 0.0 的值通常会导致生成器产生更少的意外响应。此值指定后端在调用生成器时使用的默认值。 |

0.7 |

spring.ai.vertex.ai.chat.options.topK |

采样时要考虑的最大令牌数。生成器使用组合的 Top-k 和核采样。Top-k 采样考虑一组最有可能的 TopK 令牌。 |

20 |

spring.ai.vertex.ai.chat.options.topP |

采样时要考虑的令牌的最大累积概率。生成器使用组合的 Top-k 和核采样。核采样考虑一组最小的令牌,其概率总和至少为 topP。 |

- |

spring.ai.vertex.ai.chat.options.candidateCount |

要返回的生成响应消息的数量。此值必须介于 [1, 8] 之间,包含边界。默认为 1。 |

1 |

所有以 spring.ai.vertex.ai.chat.options 为前缀的属性都可以在运行时通过将特定于请求的 运行时选项 添加到 Prompt 调用中来覆盖。

|

运行时选项

The VertexAiPaLm2ChatOptions.java 提供模型配置,例如温度、topK 等。

启动时,可以使用 VertexAiPaLm2ChatModel(api, options) 构造函数或 spring.ai.vertex.ai.chat.options.* 属性配置默认选项。

在运行时,您可以通过在 Prompt 调用中添加新的、特定于请求的选项来覆盖默认选项。例如,要覆盖特定请求的默认温度

ChatResponse response = chatModel.call(

new Prompt(

"Generate the names of 5 famous pirates.",

VertexAiPaLm2ChatOptions.builder()

.withTemperature(0.4)

.build()

));

除了特定于模型的 VertexAiPaLm2ChatOptions 之外,您还可以使用可移植的 ChatOptions 实例,该实例使用 ChatOptionsBuilder#builder() 创建。

|

示例控制器

创建 一个新的 Spring Boot 项目,并将 spring-ai-vertex-ai-palm2-spring-boot-starter 添加到您的 pom(或 gradle)依赖项中。

在 src/main/resources 目录下添加一个 application.properties 文件,以启用和配置 VertexAi 聊天模型

spring.ai.vertex.ai.api-key=YOUR_API_KEY

spring.ai.vertex.ai.chat.model=chat-bison-001

spring.ai.vertex.ai.chat.options.temperature=0.5

将 api-key 替换为您的 VertexAI 凭据。

|

这将创建一个 VertexAiPaLm2ChatModel 实现,您可以将其注入到您的类中。以下是一个使用聊天模型进行文本生成的简单 @Controller 类的示例。

@RestController

public class ChatController {

private final VertexAiPaLm2ChatModel chatModel;

@Autowired

public ChatController(VertexAiPaLm2ChatModel chatModel) {

this.chatModel = chatModel;

}

@GetMapping("/ai/generate")

public Map generate(@RequestParam(value = "message", defaultValue = "Tell me a joke") String message) {

return Map.of("generation", chatModel.call(message));

}

@GetMapping("/ai/generateStream")

public Flux<ChatResponse> generateStream(@RequestParam(value = "message", defaultValue = "Tell me a joke") String message) {

Prompt prompt = new Prompt(new UserMessage(message));

return chatModel.stream(prompt);

}

}手动配置

The VertexAiPaLm2ChatModel 实现 ChatModel 并使用 低级 VertexAiPaLm2Api 客户端 连接到 VertexAI 服务。

将 spring-ai-vertex-ai-palm2 依赖项添加到您项目的 Maven pom.xml 文件中

<dependency>

<groupId>org.springframework.ai</groupId>

<artifactId>spring-ai-vertex-ai-palm2</artifactId>

</dependency>或添加到您的 Gradle build.gradle 构建文件中。

dependencies {

implementation 'org.springframework.ai:spring-ai-vertex-ai-palm'

}| 请参阅 依赖项管理 部分,将 Spring AI BOM 添加到您的构建文件中。 |

接下来,创建一个 VertexAiPaLm2ChatModel 并将其用于文本生成

VertexAiPaLm2Api vertexAiApi = new VertexAiPaLm2Api(< YOUR PALM_API_KEY>);

var chatModel = new VertexAiPaLm2ChatModel(vertexAiApi,

VertexAiPaLm2ChatOptions.builder()

.withTemperature(0.4)

.build());

ChatResponse response = chatModel.call(

new Prompt("Generate the names of 5 famous pirates."));The VertexAiPaLm2ChatOptions 提供聊天请求的配置信息。The VertexAiPaLm2ChatOptions.Builder 是一个流畅的选项构建器。

低级 VertexAiPaLm2Api 客户端

The VertexAiPaLm2Api 提供的是 VertexAiPaLm2Api 聊天 API 的轻量级 Java 客户端。

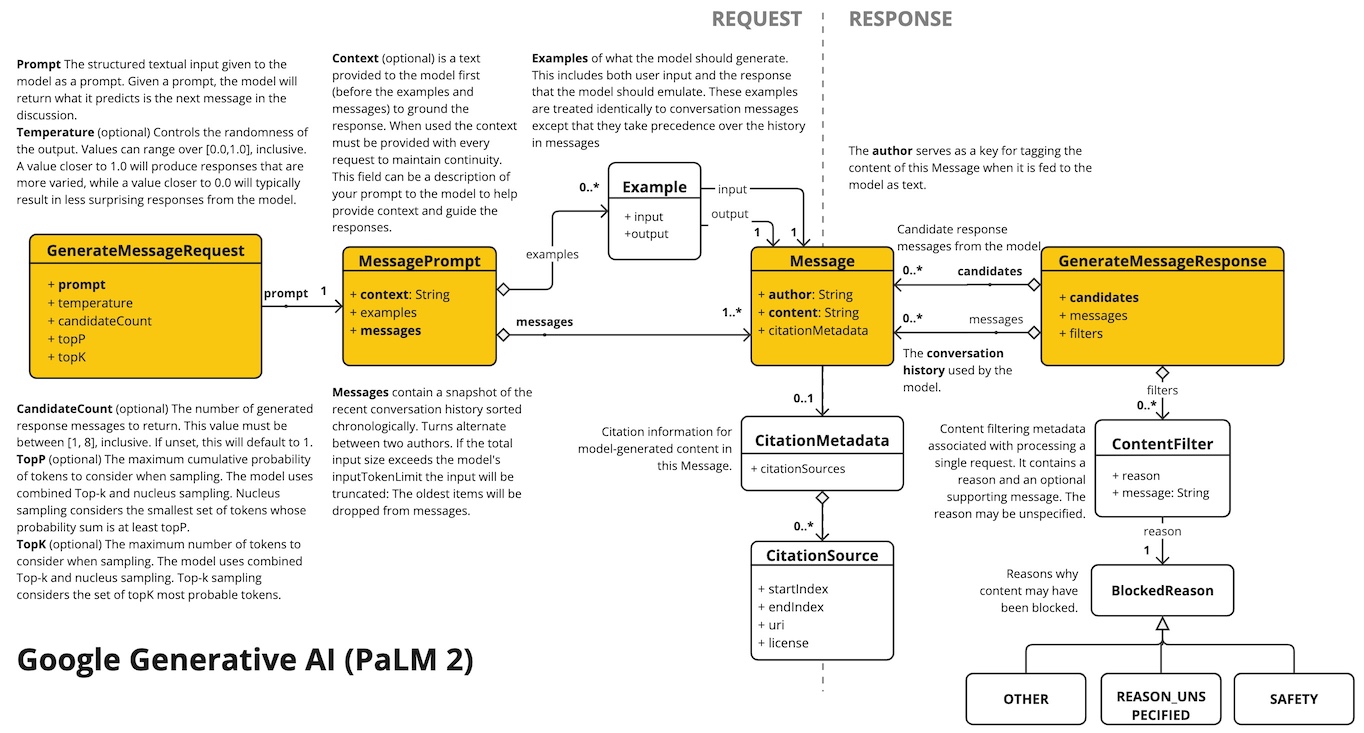

以下类图说明了 VertexAiPaLm2Api 聊天接口和构建块

以下是一个简单的代码片段,说明如何以编程方式使用该 API

VertexAiPaLm2Api vertexAiApi = new VertexAiPaLm2Api(< YOUR PALM_API_KEY>);

// Generate

var prompt = new MessagePrompt(List.of(new Message("0", "Hello, how are you?")));

GenerateMessageRequest request = new GenerateMessageRequest(prompt);

GenerateMessageResponse response = vertexAiApi.generateMessage(request);

// Embed text

Embedding embedding = vertexAiApi.embedText("Hello, how are you?");

// Batch embedding

List<Embedding> embeddings = vertexAiApi.batchEmbedText(List.of("Hello, how are you?", "I am fine, thank you!"));